|

|

Schmunzel-Ecke: ... mein Hobby ... mein Eigenbau ... mein Elektrisches ... mein Elektronisches ... meine Formeln ... mein Sonstiges ... |

|---|

|

|

Schmunzel-Ecke: ... mein Hobby ... mein Eigenbau ... mein Elektrisches ... mein Elektronisches ... meine Formeln ... mein Sonstiges ... |

|---|

(diese Darstellung ist nach meinen persönlichen Empfinden und Gedanken zusammengestelt, sie erhebt nicht den Anspruch auf Vollständigkeit!)

Es "bewegt" sich "Etwas" nach rechts - aber die Elemente (Buchstaben) bleiben immer auf der gleichen Stelle?!

|

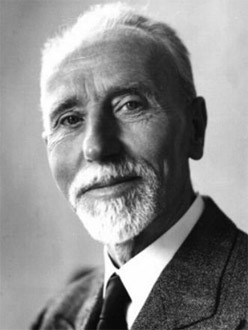

Michael Faraday

22. September 1791; † 25. August 1867 Nach Wikipedia:

Faraday: Informationen zu einigen Experimenten Faraday eigentlich in heutigen Zeit bekannt für die Entwicklung des Faradayschen Käfigs hat jedoch Unmengen Experimente zur Elektrizität und des Magnetismus betrieben, hat die Basis für den Elektromotor erfunden. Er hat aber auch Experimente zur Wirkung von Magnetismus auf Licht durchgeführt und war wohl schon davon überzeugt, dass Licht auch eine elektromagnetische Welle ist. Maxwell hat das aufgegriffen, weiterentwickelt und in Formel gepackt, denn im Gegensatz zu Faraday war Maxwell ein Theoretiker. Nach Wikipedia:

|

|

James Clerk Maxwell 13. Juni 1831; †5. November 1879 Wenn man etwas zur Entwicklung der Funktechnik sagen will, muß man unbedingt den Physiker Maxwell erwähnen. Bereits im 19-ten Jahrhundert, noch vor Einstein, hat er vorausgesagt, dass es elektro-magnetische Wellen gibt, die sich im Raum mit Lichtgeschwindigkeit ausbreiten, kein Medium brauchen (also auch im Luftleeren Raum vorhanden sind) und zur Übertragung von Informationen geeignet sind! Nach Wikipedia:

Der verbal beschriebene Zusammenhang von elektrischen und magnetischen Feldern beschreibt Maxwell durch ein Gleichungssystem, den Maxwellschen Gleichungen!

Das weiß man heute über elektro-magnetische Wellen:

Das Erstaunlichste für mich ist, dass der Mensch bis etwa 1014Hz keine "Sensoren" hat, um Wellen dieser Frequenz zu spüren oder zu sehen. Die wesentlich tieferen Frequenzen von Rundfunk, Mikrowelle oder Radar sind für uns "unmerkbar" aber für die höheren haben wir einen Sensor, das Auge, und interpretieren das als Licht. Da glüht Nichts, es schwingt nur! LED's funktionieren auf dieser Basis, das Material schwingt genau mit dieser Frequnz und das können wir sehen. Interessant ist in diesem Zusammenhang, dass es auch weiße LED's gibt, aber es gibt keine Frequenz für weißes Licht! Das wird durch technische Zusätze erzeugt, es ist aber nicht das zusammengesetzte Farbspektrum (das ergibt weiß). |

|

|

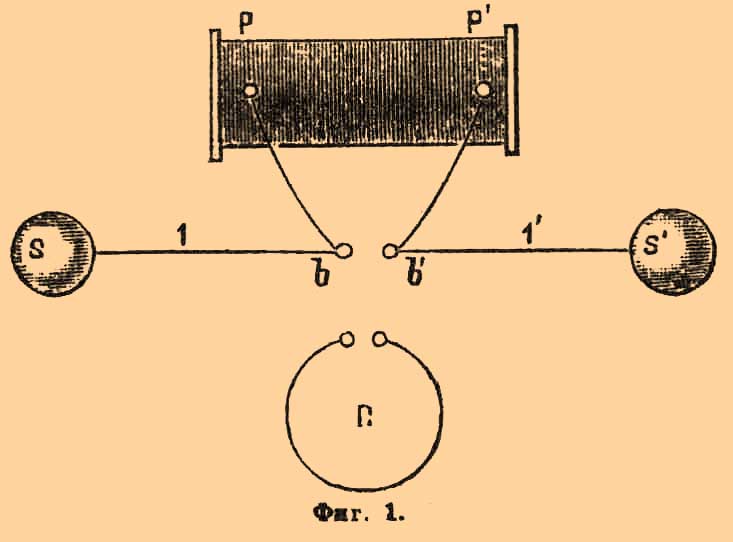

Heinrich Rudolf Hertz (22.Februar 1857; †1.Januar 1894) Auf dem Entwicklungsweg der Funktechnik ist dieser Physiker unbedingt zu nennen! Nach Wikipedia:

|

(der Versuchs-Aufbau: oben Sender; unten (Ring) Empfänger) |

|

Wilhelm "Willy" Carl Werner Otto Fritz Franz Wien (13.Januar 1864; † 30.August 1928) Nach Wikipedia:

|

|

Thomas Alva Edison (11.Februar 1847; † 18.Oktober 1931)

Edison gilt als Erfinder der Glühbirne, Nicola Teslas soll der eigentliche Erfinder

sein. Sein Verdienst ist auf jeden Fall die Einführung des elektrischen Lichts,

wozu man natürlich Glühbirnen braucht.

Edison und seine 1093 Patente |

|

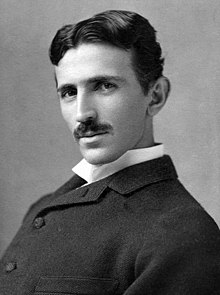

Nikola Tesla (10.juli 1856; † 7.Januar 1943)

Tesla hat sich im Streit um die Energieversorgung von Gebäuden mit

seinem Wechselstromsystem gegenüber Edison durchgesetzt.

Nach ihm wurde die Masseinheit Tesla benannt:

(Weitere Informationen unter: Tesla) |

|

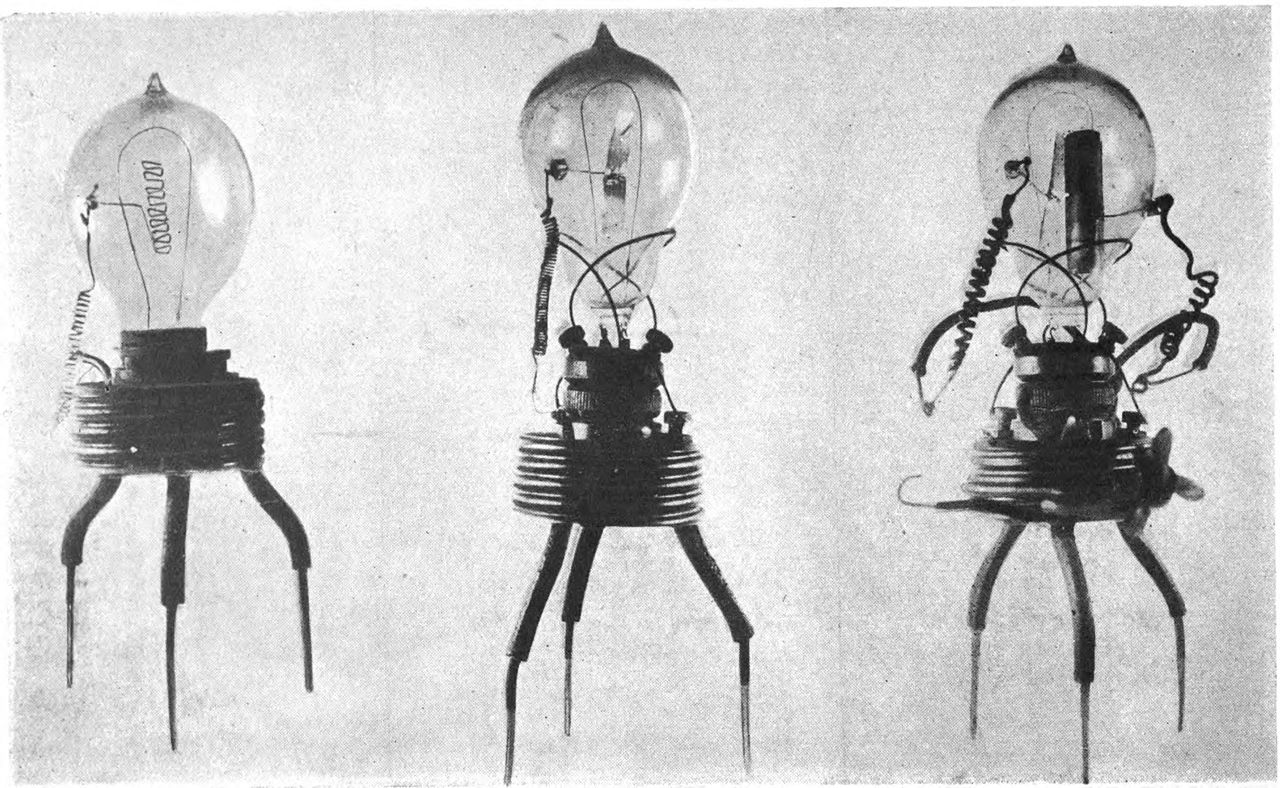

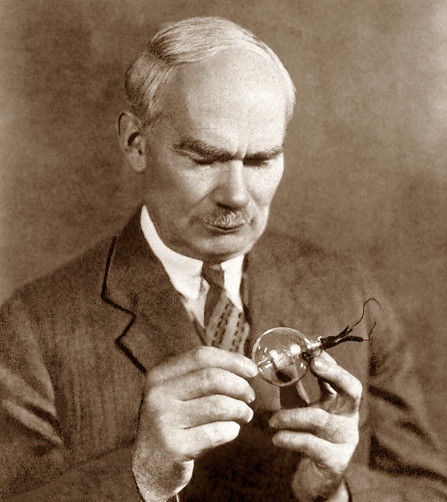

John Ambrose Fleming (29.November 1849; † 18.April 1945) Nach Wikipedia:

|

|

|

Lee De Forest (26.August 1873; † 30.Juni 1961) Nach Wikipedia:

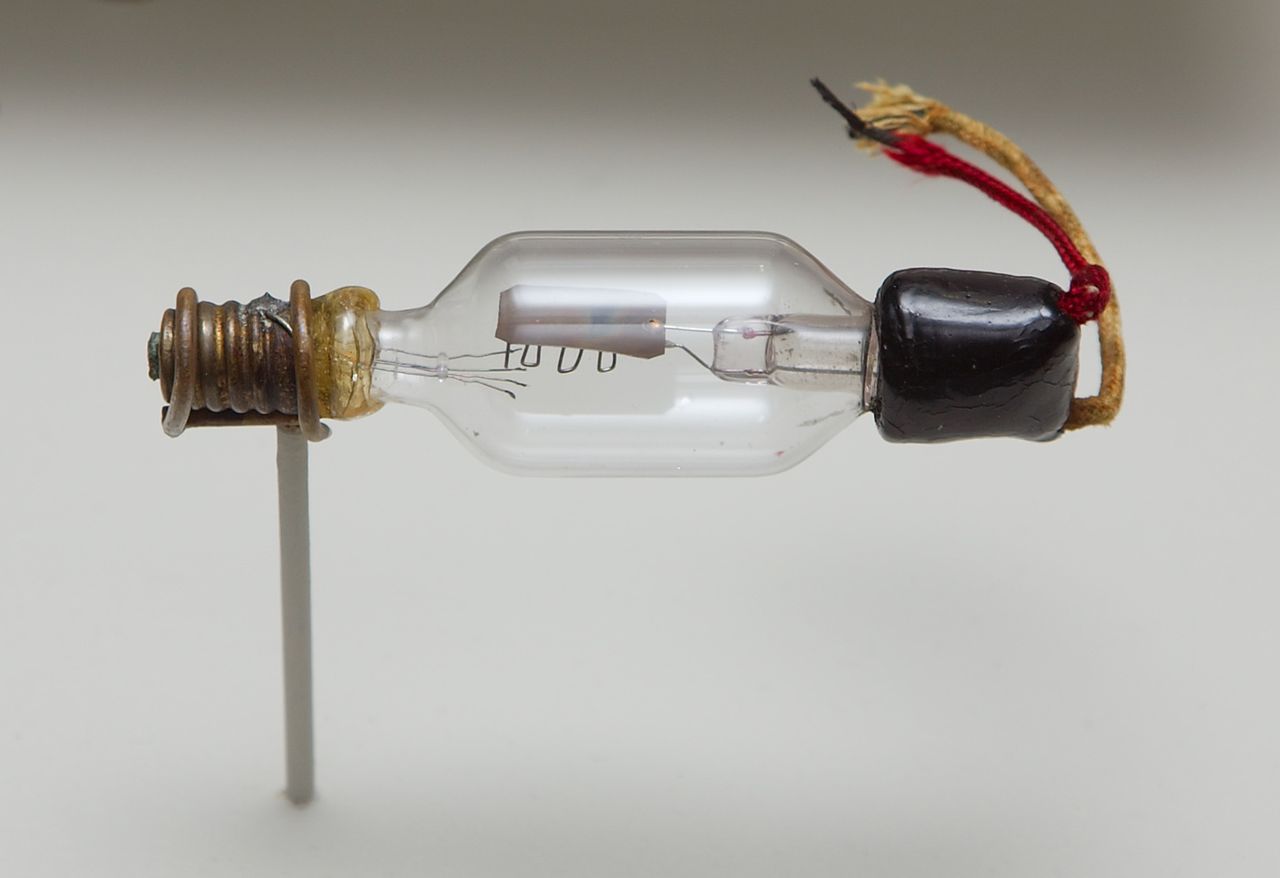

(wen es interessier, kann sich Retro-Audion-Empfänger ansehen: die Triode erinnert noch stark an eine Glühbirne => |

|

In der Folgezeit haben sich viele Wissenschaftler mit der Weiterentwicklung der

Triode zu immer weiter verbesserten Elektronen-Röhren befaßt. Insbesondere durch

neue Konstruktionen in Verbindung mit weiteren Gittern wurden Röhren für

spezielle Anwendungen geschaffen. Solche Röhren sind z.B.:

Tetrode, Pentode, Hexode, Heptode, Oktode, Mehrsystemröhren, Abstimmanzeigeröhre,

Röhren in Netzgeräten usw.

Mit den folgenden Links kann man sich selbst einen Überblick verschaffen:

|

Guglielmo Marconi (25.April 1874; † 20.Juli 1937) Nach Wikipedia:

Marconi's Versuchsaufbau: Sender und Empfänger => |

|

|

Manfred Baron von Ardenne (20.Januar 1907; † 26 Mai 1997) In diese Aufzählung der Wissenschaftler, die sich um die Verbreitung der Funktechnik gekümmert haben, sollte man auch Manfred v. Ardenne nennen. Neben vielen anderen seiner Forschungen muss man seine Forschung zu Mehrsystemröhren und die daraus entstandene Dreifachtriode, plus weiteren Bauelementen, nennen und natürlich auch die Forschung zur Kathodenstrahlröhre und die daraus resultierende Entwicklung der Fernsehübertrageng! Mit der Entwicklung der Mehrsystemröhren, kombiniert mit weiteren Bauelementen, wurde von ihm der Grundstein für integrierte Bauelemente gelegt. Nach Wikipedia:

|

|

Heinrich Georg Barkhausen (2.Dezember 1881; † 20.Februar 1956) Nach Wikipedia:

|

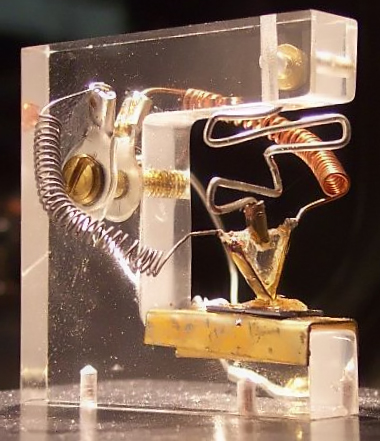

Nachbau_des_ersten_Transistors |

Transistor

Nach Wikipedia:

|

" |

|

(nach LEIFI Physik): in den 1950-er Jahren gab es einen Wettlauf zwischen der Elektronenröhre und den damals üblichen Bipolartransistoren, in dem die Chancen des Bipolartransistors wegen der vergleichsweise niedrigen Transitfrequenzen häufig eher skeptisch beurteilt wurden. Die geringe Größe, der geringe Energiebedarf und später die zunehmenden Transitfrequenzen der Transistoren führten jedoch dazu, dass die Elektronenröhren als Signalverstärker mittlerweile auf fast allen technischen Gebieten abgelöst wurden. Teilweise werden Röhren noch in der Sendetechnik im Rundfunk und bei manchen speziellen Gitarren- und Audioverstärkern verwendet. 1947 Spitzentransistor Etwa 1962 wurde die Elektronenröhre vom Transistor überholt (siehe Grafik links).

|

|

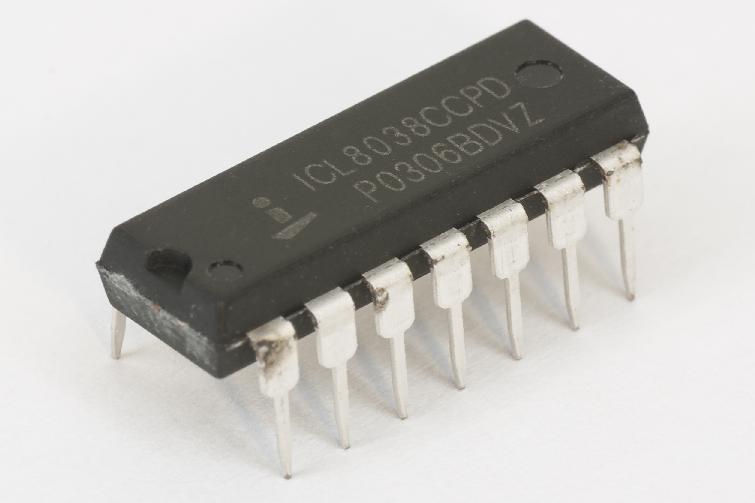

Integrierte Schaltungen

|

Es gilt dies als "erster integrierter Schaltkreis". Um ein Radio damit zu bauen waren nur wenige weitere Bauelemente notwendig. Es ist der Anfang der Entwicklung, der von Kilby beschritten wurde. Weiter ausgebaut wurde diese Variante in den 60-er Jahren von den Keramischen Werken Hermsdorf in der DDR.

|

|

Integrierte Schaltkreise

|

Den ersten "monolithischen", d. h. aus bzw. in einem einzigen einkristallinen

Substrat gefertigten, integrierten Schaltkreis meldete Robert Noyce im Juli 1959

zum Patent an. Das Entscheidende an der Erfindung von Noyce war die komplette Fertigung der Bauelemente einschließlich Verdrahtung auf einem Substrat. 1957 gründet er Fairchild Semiconductor; 1968 verließ er Fairchild Semiconductor und gründete mit Gordon E. Moore die Firma Intel! Die Entwicklung in den folgenden 60 Jahren (von Noyce 1959 bis 2019) ist rasant und unbeschreiblich:

Im Jahr 2010 enthielten Grafik-Prozessoren bis zu drei Milliarden Transistoren

(siehe Nvidia Tesla), "normale" General-Purpose-CPUs bis zu 1,17 Milliarden Transistoren

(Intel Core i7-980X).

Im Jahr 2010 enthielten Grafik-Prozessoren bis zu drei Milliarden Transistoren

(siehe Nvidia Tesla), "normale" General-Purpose-CPUs bis zu 1,17 Milliarden Transistoren

(Intel Core i7-980X). Der Itanium 2 Tukwila besteht aus 2,05 Milliarden Transistoren. Mittlerweile sind Grafikprozessoren bei Transistorzahlen von über acht Milliarden Transistoren angelangt (Nvidia GTX TitanX). Noch größere Zahlen werden bei Speicherbausteinen erreicht, bei allerdings geringerer Komplexität des gesamten Chips. |

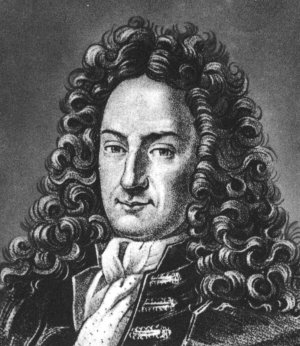

Irgendwo hier in der Aufzählung muss man noch einmal ganz weit nach hinten in die Vergangenheit

zurück greifen, denn alles folgende basiert auf der Anwendung der digitalen Rechentechnik.

Gottfried Wilhelm Leibniz (Juli 1646; † 14. November 1716) gilt als deren Erfinder! nach WikiPedia " Er war ein deutscher Philosoph, Mathematiker, Jurist, Historiker und politischer Berater der frühen Aufklärung. Er gilt als der universale Geist seiner Zeit und war einer der bedeutendsten Philosophen des ausgehenden 17. und beginnenden 18. Jahrhunderts sowie einer der wichtigsten Vordenker der Aufklärung. Im 18. Jahrhundert wird er vielfach als „Gottfried Wilhelm Freiherr von Leibniz“ bezeichnet; doch bislang fehlt eine Beurkundung über eine Nobilitierung." Zu folgenden Themen gibt es Forschungsergebnisse:

Also ein fehlerfreier Austausch von Informationen kann nur auf der Basis von Zahlen möglich sein. Er ging sogar soweit, dass er meinte, dass Denken ein Rechenvorgang sei! nach Wikipedia: " Für Leibniz galt die Devise: "Ohne Gott ist nichts." Deshalb setzte er für Gott die Eins und für das Nichts die Null." Leibniz sah sich selbst so: "Mir kommen morgens manchmal so viele Gedanken während einer Stunde, die ich noch im Bett liege, dass ich den ganzen Vormittag und bisweilen den ganzen Tag und länger brauche, um sie klar zu Papier zu bringen" Er benutzte Papier zum Aufschreiben, jede Stelle des Papiers und mit kleiner Schrift. Es kam auch vor, dass er etwas an völlig anderer Stelle schrieb, zu einem anderen Thema. Später schnitt er das Papier dann so auseinander, dass er wieder die Themen zusammenlegen konnte.

"Es ist unwürdig, die Zeit von hervorragenden Leuten mit knechtischen Rechenarbeiten zu verschwenden, weil bei Einsatz einer Maschine auch der Einfältigste die Ergebnisse sicher hinschreiben kann!" Das war die Motivation eine Rechenmaschine zu bauen.

"Im weiteren Sinne war Leibniz wegbereitend für die Rechenmaschine im heutigen Sinne, den Computer. Er entdeckte, dass sich Rechenprozesse viel einfacher mit einer binären Zahlencodierung durchführen lassen, und ferner, dass sich mittels des binären Zahlencodes die Prinzipien der Arithmetik mit den Prinzipien der Logik verknüpfen lassen (siehe De progressione Dyadica, 1679; oder Explication de l’Arithmetique Binaire, 1703). Die hier erforschten Prinzipien wurden erst 230 Jahre später in der Konstruktion von Rechenmaschinen eingesetzt (z. B. bei der Zuse Z1)!" Die oben beschrieben Rechenmaschine basierte jedoch auf dem Dezimal-Zahlensystem.

nach WikiPedia: " ... Leibniz ... Er entdeckte, dass sich Rechenprozesse viel einfacher mit einer binären Zahlencodierung durchführen lassen, und ferner, dass sich mittels des binären Zahlencodes die Prinzipien der Arithmetik mit den Prinzipien der Logik verknüpfen lassen" Auf dieser Seite werden verschiedene Möglichkeiten zur Realisierung der arithmetischen Funktion "Plus" aus logischen Funktionen (AND, XOR) dargestellt.

Leibniz...Prinzipien der Arithmetik mit den Prinzipien

der Logik verknüpfen

Wie nun die Arithmetik und die Logik verknüpft werden können, soll am folgenden Beispiel eines Addierers gezeigt werden. Die Basis eines Rechenwerks ist ein Addierwerk (Werk stammt wohl noch aus der Zeit der mechanischen Rechenmaschinen), das gilt auch für die digitale Welt. Man reduziert die Addition auf zwei Werte und da wird wie in der dezimalen Welt von rechts beginnend stellenweise die Addition für die Zahlen durchgeführt (geht auch anders).

Bei 3 Eingängen gibt es binär 8 Kombinationen, die schreiben wir einfach in eine Tabelle. Zusätzlich werden für die jeweiligen Kombinationen der Eingangswerte die Werte für die Summe und den Übertrag in die Tabelle eingetragen.

Es werden alle Zeilen, die als Ergebnis eine 1 haben (S = 1 oder/und Ü = 1) zur weiteren Bearbeitung

heran gezogen. Man stellt die Frage:

wenn a = 1 und b ≠ 1 und Ü ≠ 1 dann ist S = 1 Zuvor hatten wir bereits eine andere Schreibweise definiert, die setzen wir nun ein: a und nb und nÜ → S = 1 Das "+" und das "und" haben unterschiedliche Funktionen, das "+" ist ein arithmetischer Operator, das "und" ein logischer, es fordert Dinge, wir sprechen auch hier von Variablen, auf da zu sein. Um die Unterschiede sichtbar zu machen gibt es für "und" das Rechenzeichen ∧ oder man läßt es weg: a ∧ nb ∧ nÜ = a nb nÜ → S = 1 Und nun mit Werten: 1 ∧ n0 ∧ n0 = 1 ∧ 1 ∧ 1 = 1 Und das sind zugleich die ersten zwei logischen Gesetze: n0 = 1 gilt auch anders herum n1 = 0 und das Ergebnis einer logischen "UND"-Funktion ist nur 1 wenn alle Eingänge 1 sind.

Betrachtet man die Tabelle, sieht man, dass die Situation, dass S gleich 1 wird noch an weiteren 3 Zeilen

auftritt, also tritt das bei

Zeile 2 oder bei Zeile 3 oder bei Zeile 5 oder bei Zeile 8 auf.

Die Zeilen kann man wie eben dargestellt beschreiben: Das kann man noch vereinfachen (die Methoden kann man an anderer Stelle nachlesen) Leibniz hat vermutlich diesen Weg auch gefunden, woran es dann mangelte, waren die Möglichkeiten zur Realisierung der logischen Funktionen. Was vielleicht schon gegangen wäre, ist Pneumatik (Druckluft konnte man schon erzeugen (es gab später komplette Analogrechner auf dieser Basis), Hydraulik? und Elektrik gab es noch nicht! Offensichtlich war es zu der Zeit eine Sackgasse, es waren neue Methoden ohne Anwendung? Herr Zuse hat 200 Jahre später wohl ähnliche Gedanken gehabt und hat, da er den Relais und den Röhren nicht so recht vertraut hat, eine komplett mechanische Realisierung eines Digitalrechners erfunden, das währe zu Leibniz Zeiten auch schon möglich gewesen!

|

Rechentechnik

Gottfried Wilhelm Leibniz |

|

Digitaler Signalprozessor DSP

|

Die von Noyce 1959 ausgelöste Entwicklung ist enorm. Beflügelt durch die Schaffung

leistungsstärkerer Rechner, werden immer mehr logische Funktionen auf so einem Chip

untergebracht. Aber nicht nur für die Rechentechnik werden damit immer neuere und

weitere Möglichkeiten geschaffen, sondern auf grund der Leistungsdichte und

Geschwindigkeit können eine große Menge von Anwendungen mit dieser Technik gesteuert

werden, sind sogar erst möglich geworden.

So kann man auch neue Anwendungen in der

Funktechnik finden, so z.B. der DSP (Digitaler Signalprozessor).

Nach Kainka Elektronik Labor:

|

|

Funk-Telefon ↓

↓ |

Funksender gibt es schon eine Weile, der Wunsch war jedoch die Geräte kleiner zu

machen, so dass man sie mitnehmen konnte. Aber erst mit dem Aufbau eines kleinmaschigen Funknetzes (viele Sendemasten) war es ab der 90-er Jahre möglich die Leistung der mobilen Geräte zu verringern und somit auch die eigentlichen Funkgeräte kleiner zu bauen.

Die zuvor beschriebene Entwicklung des DSP (Digitaler Signalprozessor) hielt nun auch auf diesem Gebiet seinen Einzug. Die analogen Funksignale wurden in digitale gewandelt, bearbeitet und wieder zu analogen gewandelt und dem Lautsprecher zugeleitet. Natürlich ging der Weg auch in entgegengesetzter Richtung (das ist neu gegenüber dem "alten" DSP, vom Mikrofon zum Absenden des Funksignals (muss ja modelliert werden). Zur digitalen Bearbeitung des Signals wird ein Prozessor eingesetzt. Ist er schnell genug, hat er Zeit auch weitere Teile am Handy zu bedienen, wie z.B. einen kleinen Bildschirm einschließlich der Gestaltung und Abfrage von Bedienelementen, im einfachsten Fall Zahlen-Tasten. Die Geschwindigkeit und Leistung des Prozessors ist inzwischen so groß, dass weitere, teils völlig neue und Telefon unspezifische, Kommunikationen möglich sind - aus dem Telephon wird ein Smartphon! Nach: DIE WELT/Wirtschaft

Anmerkungen: CISC-Befehlssatz ist für einen PC notwendig, es ist eine Maschine für universelle Anwendungen, man muss alle Möglichkeiten bearbeiten können. Der RISC-Befehlssatz stellt nur die Befehle bereit, die für die Anwendung gebraucht werden, die Suche nach den Befehlen ist schneller, weil ja die Menge kleiner ist. Wird aber eine Aktion angewiesen, die eigentlich einen Befehl aus dem CISC-Satz braucht, dann muss dieser umständlich mit den vorhandenen Befehlen des RISC-Satzes erzeugt werden, das braucht dann viel mehr Zeit!. Wie eine App geladen und abgearbeitet wird, legt das Betriebssystem fest, z.B. ADROID. Es ist ein Programm, das mit dem gegebenen Befehlssatz erstellt wurde. Es werden nun 2 Bilder gezeigt, die grob den Aufbau und die Elemente eines Smartphon's zeigen (Bild links: ANDROID MAG):

Die analogen Funksignale betreffen nicht mehr nur die Telefonie (WCDMA, GSM) sondern auch GPS,

TV(DVB), NFC/RFID, FM (Radio), Bluetooth, WLAN, Infrarot usw.. Das muss alles gewandelt werden.

Alles zur gleichen Zeit werden den Prozessor überfordern. Erfahrungen zeigen, dass GPS in

Verbindung mit Navigation sehr viel Leisung brauchen, so dass das Handy sehr warm wird und

der Akku nach einer Stunde fast leer ist. Aber man kann einfach nur die notwendigen Dinge

auswählen, die anderen abschalten. Interessant sind die kleinen Kästchen unten auf dem linken Bild:

Stand: April 2021 / Handy der Firma: Xiaomi/China; Preis unter 200€ Telefon-Type: Redmi Note 9S (6GB Ram, Speicher 128GB) Octacore Max 2,32GHz (ein Kern) Oberfläche: MIUI Global 12.0.3 Das ist eine gewaltige Entwicklung die da in den letzten 30 Jahren vonstatten gegangen ist - und es ist kein Ende in Sicht! Nur Einer ist von der Entwicklung enttäuscht:Cooper, der Erfinder des Handy's, hatte eine schnellere Entwicklung gedacht, jeder Mensch sollte bei Geburt eine Telfonnummer bekommen, als Chip gleich implementiert und er sollte mit seinen Gedanken wählen und so mit anderen Menschen Kontakt aufnehmen können - das dauert wohl noch ein bißchen! |

Wenn die Menschen so kommunizieren, alles was sie sich merken wollen in einem zentralen Speicher ablegen, bzw. alles dort "nachlesen" können (wir habe ja schon Cloud's und Google und Cortana und Co erklären alles auf Anfrage, es gibt Sprachnachrichten), dann brauchen die Menschen nicht mehr lesen und schreiben zu können, auch rechnen erledigt der zentrale Speicher, braucht man dann auch nicht mehr, alle visuellen Informationen können dann aber nur noch als Farbe oder Symbol dargestellt werden, was wir durchaus heute schon haben z.B. Verkehrszeichen, dann hat sich das ganze Leben komplett verändert.

Dazu ein paar aktuelle Informationen (Oktober 2019):

(nach t-online.de): "Darum lassen sich Menschen Mikrochips implantieren

Eine verschlossene Tür ohne Schlüssel öffnen: Mikrochips unter der Haut machen das möglich.

Rund 3000 Schweden nutzen die implantierte Technologie bereits!"

|

|

Momentan sind die Möglichkeiten noch ziemlich begrenzt, was an der Größe des Chips liegt. 880 Bytes sind um einiges weniger, als man für einen durchschnittlichen MP3-Musikordner benötigt. Das dürfte sich jedoch bald ändern, da die Biochips im Laufe der Jahre ständig weiterentwickelt werden. | |

| (zwischen Daumen und Zeigefinger befinden sich die Chip's) | |||

Aber

so wie wir immer Update's machen müssen, um das System von Fehlern zu beseitigen und

unerwünschte Zugriffe zu verhindern, kann dann auch der Zugriff auf den Menschen erfolgen,

er ist dann sehr leicht manipulierbar!!!

| KI - ChatGPT |

|

|

DNA - als Speicher |

|

Nun kommt Prof. Philippow wieder ins Spiel In den Lehrveranstaltungen zur "Theoretischen Elektrotechnik" wurde uns von ihm so eingeprägt:

z.B. es gibt keinen besseren (preiswerten) Leiter als Kupfer, so sollte man völlig erstaunt sein, dass es ein Material "Graphen" (siehe unten) gibt, was durchaus insgesammt bessere Eigenschaften hat. Vor kurzem haben Wissenschaftler anhand eines mathematischen Theorems noch dargelegt, dass solche Strukturen nicht existieren können - und es gibt sie doch! Da muss wohl auch das Theorem nicht richtig oder falsch angewendet worden sein. Prof.Dr.sc.techn.Dr.h.c.mult. E.Philippow (†) |

Eines der allgegenwärtigsten Teilchen im Universum, das Myon, gibt Forscherinnen und Forschern in der Physik Rätsel auf: Es verhält sich nicht, wie sie es erwarten. Tatsächlich weicht das Myon so sehr von den physikalischen Gesetzen ab, dass die physikalische Forschung inzwischen davon ausgeht, ihre Gesetzesannahmen noch einmal überprüfen zu müssen.

Gibt es eine Kraft im Universum, von der wir noch nichts wissen? Myonen sind wie dicke Elektronen: Sie haben eine negative Ladung, sind aber 207 Mal schwerer als Elektronen. Dank ihrer Ladung und eines Drehimpulses, der Spin genannt wird, verhalten sie sich wie winzige Magneten. Werden Myonen in ein anderes Magnetfeld getaucht, kommt es zu einem winzigen Rotieren.

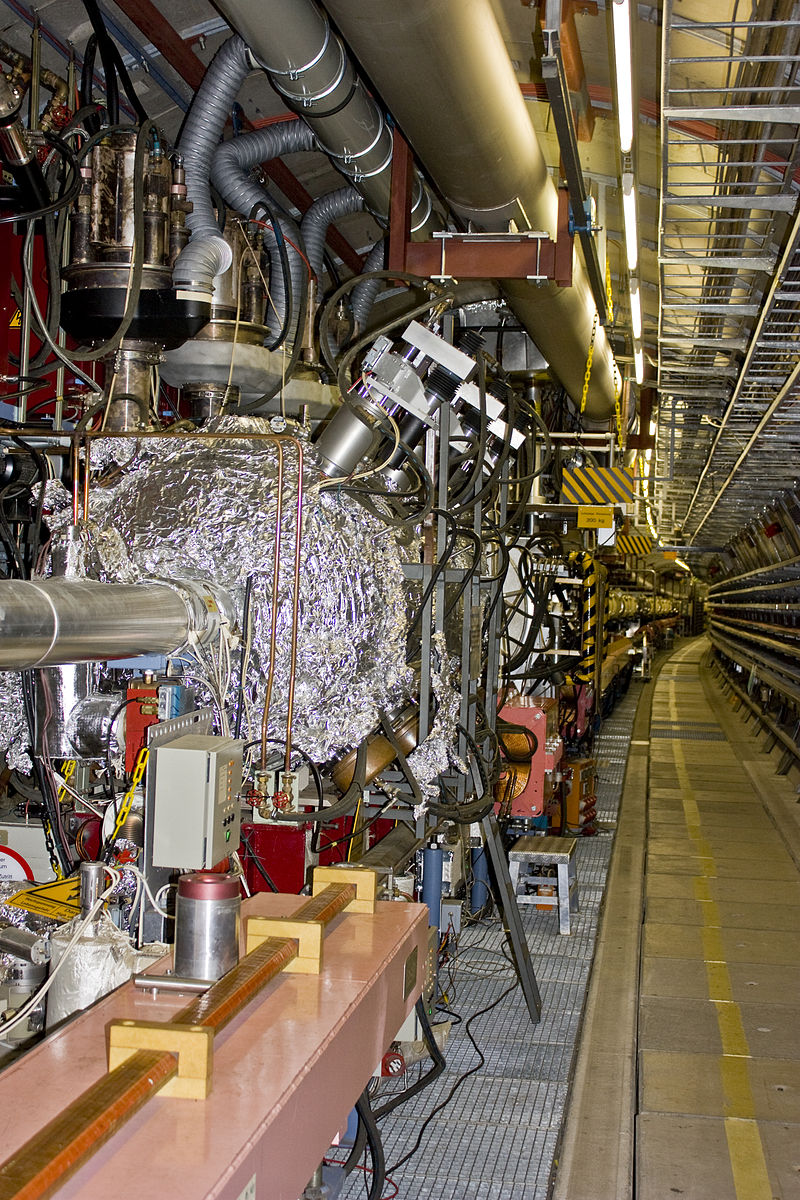

|

Das ist der Ring-Beschleuniger in den USA, mit dem das Myon nachgewiesen wurde. ← In Hamburg gibt es auch so einen Beschleuniger, das DESY (Deutsches Elektronen-Synchrotron) Der Ring hat einen Umpfang von 6336m. Die Elektronen und Protonen werden fast auf Lichtgeschwindikeit beschleunigt (entgegengesetzt) und müssen durch supra-leitende Magnete auf die Kreisbahn gezwungen werden. Es ist schon beachtlich die Technik im Tunnel, bin schon einmal darin rumgelaufen, natürlich nicht im Betrieb, das hätte wohl Einfluss auf den Geist! → |

|

|

Die atmosphärischen Myonen sollten aufgrund ihrer kurzen, mittleren Lebensdauer von 2.197 Mikrosekunden am Erdboden gar nicht nachweisbar sein. Dies ist trotzdem gelungen! Man erklärt dies mit der Speziellen Relativitätstheorie: da sich die Myonen mit Geschwindigkeiten bewegen, die vergleichbar sind mit der Lichtgeschwindigkeit, werden relativistische Effekte wirksam. Die Zeitdilatation dehnt die Zerfallszeit im Ruhesystem gegenüber der Zeitspanne im Beobachtersystem aus. Dadurch können die Myonen einen längeren Weg durch die Atmosphäre zurücklegen als klassisch abgeleitet: sie schaffen es bis auf den Erdboden!

Plastik - Elektronik

|

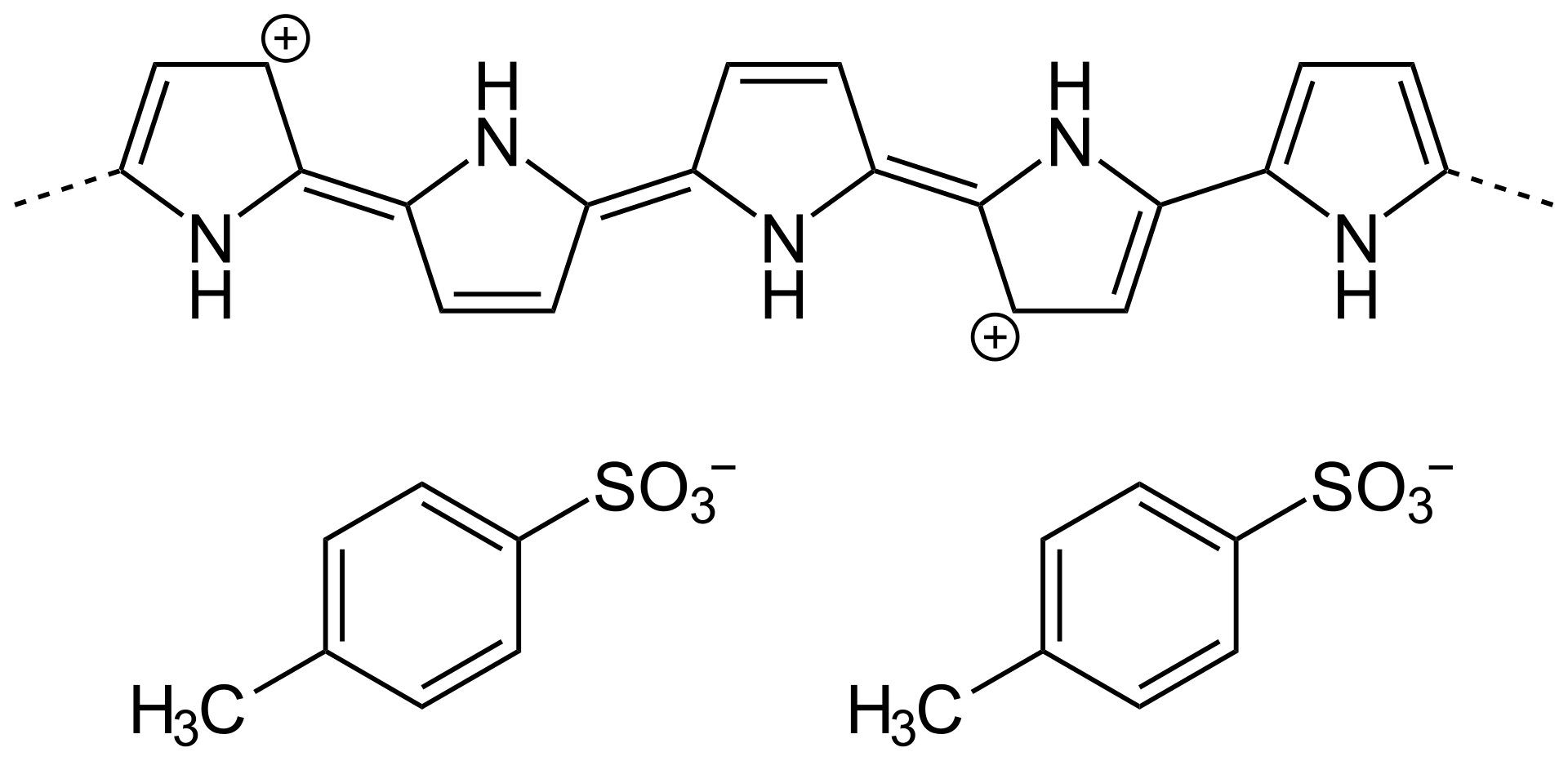

Parallel zu neuen Anwendungen wird natürlich auch immer nach neuen Materialien geforscht, so entsteht z.Z. ein neues Gebiet "Plastik-Elektronik". Das kann man gar nicht glauben, dass Plasik etwas in der Elektronik zu tun hat - als Isolator schon, aber als Leiter? Man kennt z.B. als elektronische Bauelemente Feldeffekt-Transistoren. Neben den schon bekannten Typen MOS-FET und den weniger bekannten J-FET gibt es auf einmal auch O-FETs! Das "O" steht für organisch. Was bedeutet "organisch"? Das hat nichts mit Organen von Menschen oder Tieren zu tun, es ist ein aus der Chemie abgeleiter Begriff. Da kennt man die Organische und die Anorganische Chemie, Teile der verwendeten Werkstoffe für die OFETs entstammen der organischen Chemie und deren Verbindungen.Das ist auch deshalb sehr interessant, da diese Materialien auch in anderen elektronischen Produkten genutzt werden könnten, z.B. LEDs (OLEDs gibt es wohl schon), Displays, Solarzellen, organische Speicher usw. Der Vorteil ist, man kann den Einsatz von Silizium und seltenen Erden reduzieren, die Produkte haben neue Eigenschaften, z.B.leicht und biegsam.

Aufbau OFETs

Dieses neue Fachgebiet ist die Organische Elektronik (Plastikelektronik)

|

Ein neues Material - mit tollen Eigenschaften - das Material der Zukunft?

Graphen nach Wikipedia:|

|

|

|

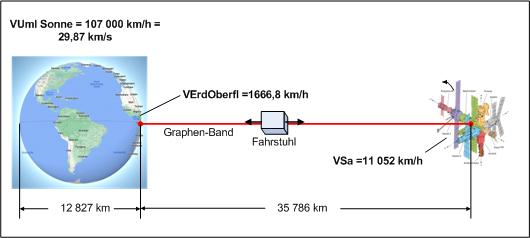

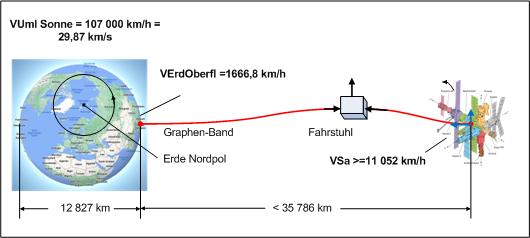

Wenn man sich nun anstelle des Körpers der Gebetsmühle die Erdkugel vorstellt, dann würde

das Gewicht bei entsprechender Länge des Bandes, Graphen-Band 35.786 km, synchron mit der Erdoberfläche sich

bewegen! Dann könnte man wie mit einem Fahrstuhl sich in den Kosmos bewegen -

aber es gibt ein paar Probleme: - Man braucht ein Gewicht am Ende des Seils. Dieses Gewicht müsste mit der Raumfahrttechnik zu dieser Stelle gebracht werden. - Das Seil braucht auf der Erdoberfläche eine Verankerung da kann ich mir gewaltige Belastungen vorstellen. - Antrieb des "Fahrstuhls" wenn das mit Strom erfolgen soll, könnte es schwierig werden. Natürlich hat man den Superleiter Graphen - die Frage ist natürlich wie? |

|

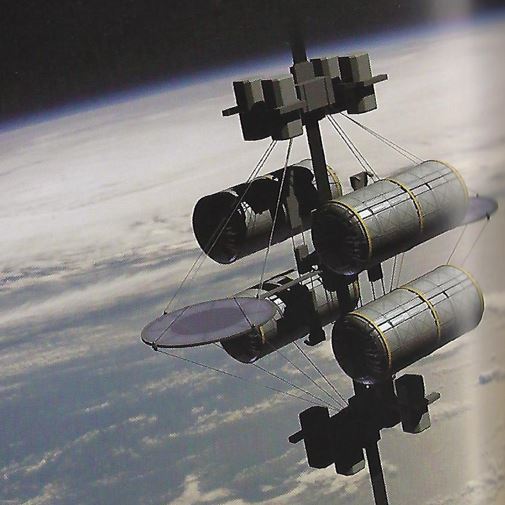

So einfach ist es nun auch wieder nicht! Der Satellit muss auf einer geostationären Bahn, d.h. in 38786km über der Erde, stationiert und mit dem Seil verbunden werden, so dass ein Andocken im luftleeren Raum möglich ist. Auf der Erde muss das Gegenstück vom Seil am Äquator sehr fest verankert werden. Das sind hier Kräfte die durch den Satelliten im Weltraum erzeugt werden, aber auch solche, die in der Atmosphäre möglich sind, z.B. Sturm. Man muss auch einmal die Zeit für den Transport betrachten: Es werden bei einem Tempo von 100km/h etwa 15 Tage bis zuer Station gebraucht! Auch wenn man schneller fahren kann, man braucht Versorgungseinrichtungen, Schlafen, Essen, Wasser, Abwasser, Atemluft, Elektrik usw. - es muss wie eine Raumstation funktionieren. |

|

Die Problematik Weltraumlift wird ausführlich beschrieben in: "Eugen Reichl; Motorbuchverlag 2012, Stuttgart" Angestoßen wurden diese Gedanken durch den "Science-Fiction-Autor: Arthur C. Clarke; (deutsch) Fahrstuhl zu den Sternen, 1979" bzw. "Frank Schätzing; Limit, 2009" |

|

so etwa stellen sich die Autoren den Fahrstuhl vor - es ist eine Plattform mit vielen Transportmöglichkeiten. |

|

Mit dem Superwerkstoff Graphen tut sich nun erneut eine mögliche Realisierung dieser

Idee auf. Aber es sind viele Probleme zu berücksichtigen. Je näher der Fahrstuhl dem Satelliten kommt, um so mehr wirken nun auch die Gesetze der "Himmelsmechanik". Der Fahrstuhl wird selbst Satellit und hat, da er zunächst noch unterhalb der geostatischen Höhe liegt, ein größere Geschwindigkeit als der Zielpunkt. Die Folge ist er weicht zur Seite aus und zieht an dem Seil. Der Satellit wird aus seiner Bahn gezogen, er wird schneller, er ist nicht mehr geostabil. Das repariert sich in der folgenden Zeit nicht mehr - das Seil muss reißen oder alles schlägt in 35000km Entfernung auf der Erde auf (es wird sicher verglühen). Ich glaube man kann nur den Fahrstuhl durch einen Raketenantrieb auf der geraden Bahn zum Satelliten halten. |

Auf Grund der Schwächung von sichtbarem Licht (alle Frequenzen) um 2,3% wird aber die Hängematte

selbst nicht zu sehen sein - die "Katze schwebt".

Legt man mehr als 10 Schichten Graphen übereinander, erhält man Graphit.

Graphen verhält sich durch das Fehlen einer Bandlücke als

Elektrischer Leiter Spezifischer elektrischer Widerstand 31Ωm

Grundlagenforschung und mögliche Anwendung

Auf Grund der Schwächung von sichtbarem Licht (alle Frequenzen) um 2,3% wird aber die Hängematte

selbst nicht zu sehen sein - die "Katze schwebt".

Legt man mehr als 10 Schichten Graphen übereinander, erhält man Graphit.

Graphen verhält sich durch das Fehlen einer Bandlücke als

Elektrischer Leiter Spezifischer elektrischer Widerstand 31Ωm

Grundlagenforschung und mögliche AnwendungGraphen-Akku: Potenzial und Funktion Graphen - es leitet Strom eineinhalbmal besser als Kupfer. Damit qualifiziert es sich als essenzielles Bauteil schnell aufladbarer Energiespeicher.

Fazit: Graphen in der Welt von Morgen

Die zukünftigen Pläne der Forscher mit Graphenmaterial scheinen direkt aus Science-Fiction-Filmen zu stammen: Fernseher,

die als Tapeten ausgerollt werden können und faltbare Bildschirme. Forscher erwarten trotz der aktuellen Unsicherheiten

bahnbrechende Forschungserkenntnisse in den nächsten Jahren.

Dezember 2022 - ist Graphen noch interessant - was ist der Stand

Graphenbatterien: Technologie mit Zukunftspotential Graphen-Akku

|

nach: (https://energyload.eu/stromspeicher/graphen-batterie/#graphenbatterien)

Härter als Stahl, leichter als Luft und fast unbeschränkt leitfähig: Seit

seiner Entdeckung im Jahr 2004 hat das „Wundermaterial“ Graphen immer mehr an Aufmerksamkeit

gewonnen. Was vor einigen Jahren lediglich Zukunftsvisionen waren, entwickelt sich nun

zur Realität: Die ersten Graphen-Batterien sind bereits auf dem Markt: Elektroautohersteller

wie Toyota kündigen schon dieses Jahr den serienreifen Graphenakku an und auch in etlichen

anderen Bereichen kommt Graphen längst zum Einsatz. |

Graphenakkus und deren Vorteil gegenüber Lithium-Ionen-Batterien

Lithium-Ionen-Batterien sind bislang die vorherrschende Technologie sowohl in Smartphones

und Laptops als auch in den meisten Elektroautos. Das besondere an Graphen-Akkus ist,

im Vergleich zu den Lithium-Ionen-Batterien, unter anderem die vergleichsweise wesentlich

schnellere Ladezeit. Dazu kommt, dass Graphen-Akkus ein geringeres Gewicht haben, relativ

temperaturunempfindlich sind und mehr Speicherkapazität aufweisen. Die Liste setzt sich fort.

Klar ist also, dass Graphenakkus in nicht allzu ferner Zukunft einen ernstzunehmenden

Konkurrenten zur Lithium-Ionen-Technologie darstellen könnten.

Die Gewinnung von Graphen wird immer kostengünstiger

Eine der größten Hürden der Nutzung von Graphen war bislang der enorm hohe Preis.

Bis zu 200.000 US Dollar musste man bis vor kurzem für eine Tonne Graphen bezahlen.

Der Grund dafür ist der aufwändige Herstellungsprozess des Materials. Dabei kamen unter

anderem aggressive Chemikalien zum Einsatz, was die Herstellung von Graphen auch

umwelttechnisch weniger attraktiv machte.

Was macht Graphen-Batterien so besonders?

Graphenbatterien, oder auch die aufladbaren Graphenakkus, stellen, verglichen mit den bisher

verfügbaren Batterien und Akkus, eine deutliche Verbesserung dar. Graphenakkus sind

wesentlich leichter als herkömmliche Akkus, da viel weniger Kohlenstoff verwendet werden

muss, um dieselbe Leitfähigkeit zu erreichen. Daher könnte besonders im Bereich der

Elektromobilität der Einsatz von Graphen zu großen Erfolgen führen.

Darüber hinaus können mit Graphen angereicherte Akkus sehr viel schneller geladen werden.

Die Ladezeiten können so von einigen Stunden auf wenige Minuten verkürzt werden.

Nicht nur in Batterien kommt das Wundermaterial zum Einsatz, auch im Bereich der

Superkondensatoren sind durch die Nutzung von Graphen große Fortschritte gelungen.

Ein Graphen Superkondensator oder Supercap besteht lediglich aus zwei Lagen Graphen,

die durch eine Elektrolytschicht voneinander getrennt sind.

Anders als in Batterien besitzen Kondensatoren kein chemisches Potential, sonders

speichern Energie in Form eines elektrischen Feldes. Zwar können Supercaps nicht so

viel Strom speichern wie Batterien, doch kann die gespeicherte Energie sehr viel

schneller abgegeben werden. Gleichzeitig geht auch der Ladevorgang wesentlich

schneller von statten.

Das Aufladen dauert etwa 20 Sekunden und wird während des „Halts“ an den Stationen durchgeführt! Damit könnten dann die Züge auf der alten Strecke ebenfalls elektrisch fahren

Die Superkondensatoren aus Graphen könnten hier sicher für einen großen Sprung sorgen.

Physikerinnen und Physiker der University of Arkansas suchen schon lange nach zeitgemäßen

Lösungen. Ihnen ist es nun gelungen, einen Schaltkreis zu entwickeln, welcher die thermische

Bewegung von Graphen einfangen und in elektrischen Strom umwandeln kann.

"Eine auf Graphen basierende Schaltung zur Energiegewinnung könnte in einen Chip eingebaut

werden, um kleine Geräte oder Sensoren mit sauberem, unbegrenztem Strom bei niedriger

Spannung zu versorgen",

erklärt Paul Thibado, Professor für Physik und leitender Forscher.

Sein Team hat herausgefunden, dass die thermische Bewegung von Graphen bei Raumtemperatur

tatsächlich einen Wechselstrom in einem Stromkreis erzeugt:

eine Beobachtung, die lange Zeit als unmöglich galt.

|

Graphen kann sich so verformen, dass daraus elektrische Energie entsteht.

Die Idee, Energie aus Graphen zu gewinnen, war bei Forschenden lange Zeit umstritten.

Denn sie widerlegt die bekannte Behauptung des Physikers Richard Feynman, dass die

thermische Bewegung von Atomen, die so genannte Brownsche Molekularbewegung, keine Arbeit

verrichten kann. Und in den 1950er-Jahren veröffentlichte der Physiker Léon Brillouin

eine bahnbrechende Arbeit, in der er die Idee widerlegte, dass das Hinzufügen einer

einzelnen Diode zu einem Schaltkreis die Lösung für die |

|

|

2018 stapelten Wissenschaftler des Massachusetts Institute of Technology zwei Ebenen des Materials (Graphen) und verdrehten sie um exakt 1,1Grad gegeneinander. Verblüfft stellten sie fest, dass Graphen dadurch zum Supraleiter wird. |

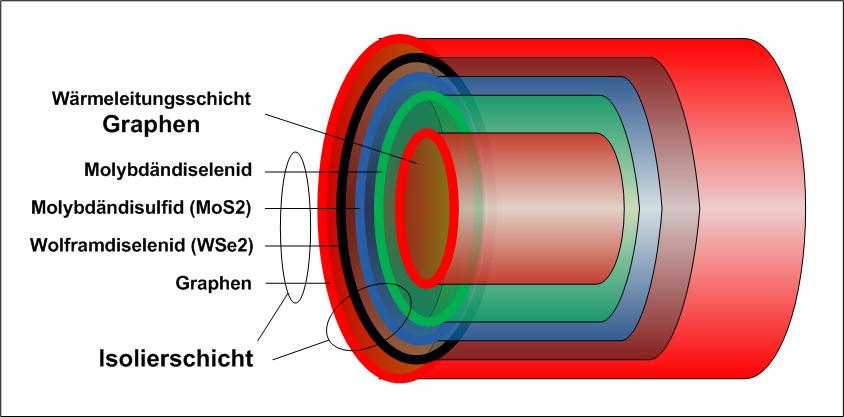

Wärmeleitung

|

Isolierschicht: 3 Nanometer dicken Schichtkomposit aus Graphen, Molybdändiselenid,

Molybdändisulfid (MoS2)

und Wolframdiselenid (WSe2). Der dünne Schichtmix blockierte Hitze fast 100-mal besser

als typisches Einfachfensterglas Eine Art Temperaturdraht, in dem Wärme gezielt etwa von Temperaturhotspots in Geräten abtransportiert wird – wobei die Temperatur nach innen abgeschirmt ist wie Strom in isolierten Drähten. (Die Reihenfolge und Anordnung der Schichten ist mir unbekannt, es ist eine symbolische Darstellung) Diese Leitung wird von einem Temperatur gefährdetem Bauteil in einer Schaltung nach außen gelegt und führt die Wärme ab. |

|

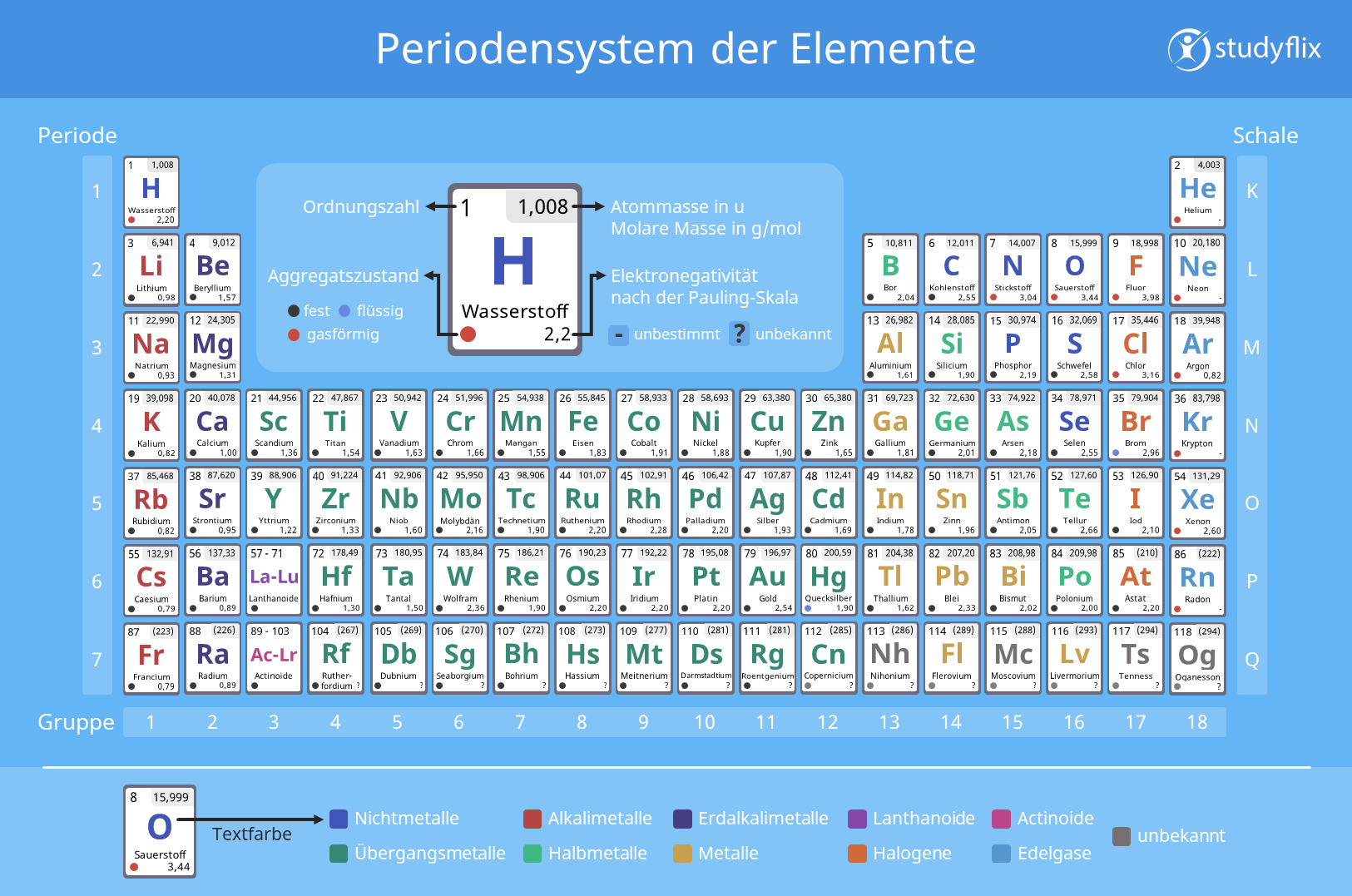

Das Periodensystem der Elemente zeigt ja, dass in der Gruppe (Spalte 14/2) von Kohlenstoff

weitere Elemente mit der gleichen Wertigkeit zu finden sind. Es ist anzunehmen, dass nach dem Erfolg mit Graphen auch andere Elemente insbesondere dieser Gruppe in dieser Richtung untersucht werden, wohlwissend, dass das Mermin-Wagner-Theorems für diese bzw. einige Fälle nicht gilt, es könnte sich lohnen. Es wäre durchaus denkbar, dass Materialien mit völlig neuen Eigenschaften entstehen. Allerdings funktioniert die Herstellung der atomaren Schicht sicher anders als von Graphit zu Graphen. Aber auch Elemente anderer Gruppen könnte interessant sein, denn aus 4-wertigen Elementen könnten stabile Viereckstrukturen entstehen (das denke ich so)? |

Februar 2023: Graphin - eine neue Form von Graphen

|

Graphin - das bessere Graphen? |

|

|

|

Zur Abgrenzung vom normalen Graphen nennen die Forscher das neue Material: Graphin. |

| AKKU |

|

Akku - ein wichtiges Arbeitsgebiet! |

| Photovoltaik |

|

Sonne als Energie-Quelle - Prinzip - neue Verfahren |